Co powoduje że aparat może zostać uznany jako dobry? Że efekt końcowy, czyli zdjęcie będzie pożądanej jakości? Uważa się, że są to matryca i optyka.

Często też zwraca się uwagę na znaczenie oprogramowania, które to m.in. narzuca nam algorytmy odszumiania. Matryca i obiektyw mają za zadanie zarejestrowanie zdjęcia w jak najlepszej jakości. Natomiast zadaniem oprogramowania jest zapis tego zdjęcia (z matrycy na nośnik pamięci) do konkretnego formatu bez zbędnych strat na jakości. Jeżeli użytkownik wybierze (jeżeli jest taka możliwość) zapis zdjęcia do formatu RAW wówczas na kartę pamięci zastaną zapisane nieprzetworzone dane wygenerowane przez matrycę. W tym wypadku o stratach nie ma mowy. Natomiast w przypadku zapisu zdjęcia do formatu .JPG (.JPEG) w wyniku procedury powstawania pliku wynikowego takie straty powstają.

Proces taki składa się z kilku etapów:

- Przetwarzanie A/C + dodawanie informacji o matrycy

- Interpolacja Bayera

- Balans, bieli, kontrast, nasycenie, wyostrzenie

- Kompresja JPG

Co to jest matryca?

Pojęcia matryca w znaczeniu ogólnym używamy dla określenia formy do wykonywania kopii. W fotografii cyfrowej matryca zastąpiła chemiczny nośnik światłoczuły (fotografia analogowa). Matryca taka rejestruje kopie obrazu, który to trafia do niej w postaci wiązki świetlnej przez obiektyw (tzw. ścieżka optyczna). Jest ona obok optyki jednym z najistotniejszych elementów w aparacie determinującym jakość zdjęć. Ludzie często błędnie określają mianem matrycy wyświetlacz aparatu fotograficznego.

Rodzaje matryc:

Na rynku dominują dwa rodzaje matrycy, są to CCD i CMOS.

CCD – Każdy z elementów światłoczułych rejestruje, a następnie pozwala odczytać sygnał elektryczny proporcjonalny do ilości padającego na niego światła.

CMOS – Nowsza generacja matryc, w których to każdy z pikseli ma swój przetwornik napięcia, więc wykazuje większa niezależność od innych, sąsiednich pikseli. Dzięki temu, gdy dany piksel nie doczyta sygnału lub zarejestruje go niepoprawnie, to tylko on pozostanie z defektem, a nie jak w przypadku matrycy CCD też inne sąsiednie.

Matryce CMOS oprócz małych zakłóceń w przesyłaniu danych wykazują mniejsze zapotrzebowanie na energię, szybki odczyt i możliwość odczytu wybranych pikseli (wykorzystywane przy ustawianiu ostrości).

Jako wady matryc CMOS wymienia się mniejszą dynamikę, szybciej powstające zakłócenie przy długich czasach naświetlania i niejednorodne parametry poszczególnych pikseli przy danym oświetleniu utrudniające proces ujednolicenia odczytu.

Matryce typu CMOS są coraz bardziej popularne a ich przewaga uwidacznia się szczególnie w lustrzankach. Pierwsze próby zastosowania tych matryc w aparatach kompaktowych były nieudane. Wraz ze wzrostem czułości (mało światła) następował nieproporcjonalnie szybki przyrost zaszumienia. Natomiast teraz to wszystko jest dopracowywane i coraz więcej aparatów kompaktowych jest wyposażana w CMOS. Oczywiście można dyskutować czy aby na pewno to CMOS jest lepsze od CCD..ale mimo rozmaitych, często uzasadnionych wątpliwości, wiele wskazuje na to, że tendencja wypierania CCD przez CMOS zostanie podtrzymana. Przyjęło się powszechnie, że CMOS to matryca nowej generacji o bardziej złożonej konstrukcji i to oczywiście jest prawdą. Zazwyczaj kończy to rozważania w tym temacie, już dalej się nie analizuje się plusów i minusów matryc CMOS. Czy istotne jest jaką będziemy mieli matryce w swoim aparacie? Oczywiście to jest ważne, ale nie najważniejsze, szczególnie w przypadku aparatów kompaktowych.

Ilość pikseli

Czy ilość pikseli jest istotna? Jest, ale nie zawsze im więcej tym lepiej. Często klienci nie wiedząc czym się kierować przy wyborze aparatu zwracają uwaga na ilość pikseli, czasami tylko i wyłącznie na to. Może wynika to z czasów, kiedy pierwsze aparaty cyfrowe miały po 2 megapiksele i wtedy rzeczywiście 3, 5 pikseli to niewątpliwie było coś lepszego. Niestety okazało się, że ta zasada działa tylko do pewnego momentu. Po przekroczeniu przyjmijmy (bo to jest wartość umowna) 8 mpx aparaty, a właściwie ich matryce zaczęły generować nadmierne zaszumienie, czyli defekty jakościowe. Po prostu pikseli było za dużo, za gęsto. Więcej pikseli pozwala nam wykonać większe zdjęcie, mniej daje nam za to lepsza jakość zdjęcia w postaci mniejszego zaszumienia.

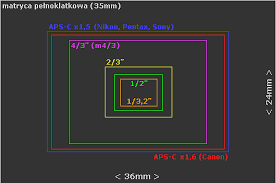

Wielkość matrycy

Chodzi tu o wielkość fizyczną. Jest to bardzo istotny aspekt. Można tu bez nadużycia uogólnić – im większa tym lepsza. Te większe matryce są stosowane a aparatach z wyższej półki. Załóżmy że mamy 10 mpx na matrycy w aparacie kompaktowym o wielkości 1/1.7 (9,5 x 7,6 x5,7 mm) i tyle samo pikseli na matrycy w lustrzance na matrycy formatu DX (28,4 x 23,6 x 15,8 mm). Oczywiste w tym przypadku jest że mniejsze zagęszczenie piksli i lepsza jakość będzie na matrycy większej tj. DX.

Reasumując,

matryca jest obok optyki najistotniejszym elementem cyfrowego aparatu

fotograficznego. Rejestruje obraz i determinuje jakość zdjęcia. Matryce

różnią się wielkością, ilością megapikseli oraz rodzajem (CCD i CMOS).

W

matrycach typu CMOS każdy piksel ma swój przetwornik napięcia, czyli

pracuje niezależnie od innych. Dlatego jeżeli błędnie zarejestruje lub

nie zarejestruje obrazu, nie wpływa na inne piksele. Z reguły przekłada

się to na lepszą jakość, szczególnie przy matrycach większych fizycznie.

Większa

ilość pikseli stwarza możliwość zrobienia większego zdjęcia. Z takiego

zdjęcia możemy wydrukować nawet ogromne plakaty. Z drugiej strony

powoduje ona większe zagęszczenie pikseli (szczególnie na małych

fizycznie matrycach) co jednoznacznie negatywnie wpływa na jakość

zarejestrowanego obrazu w postaci większego zaszumienia i mniejszej

ilości szczegółów.

Im

większe fizycznie matryca tym lepiej. Niestety te większe są droższe w

produkcji i są najczęściej stosowane w aparatach z wyższej półki.

.jpeg)